Làm Thế Nào Để Đảm Bảo Tính Minh Bạch của Tác Nhân AI? Từ “Hộp Đen” Đến Giải Pháp

Vấn Đề ‘Hộp Đen’ trong Tác Nhân AI Là Gì?

Vấn đề ‘hộp đen’ trong tác nhân AI là thách thức trong việc hiểu lý do tại sao một hệ thống tự động đưa ra một quyết định cụ thể hoặc thực hiện một hành động nhất định. Đạt được tính minh bạch của tác nhân AI là thực hành triển khai các hệ thống và phương pháp để làm cho quy trình tư duy nội bộ của chúng có thể giải thích được tối đa. Đây là một yếu tố quan trọng trong việc xây dựng các hệ thống tự động an toàn, đáng tin cậy, và hiệu quả.

Thách thức này không chỉ mang tính học thuật; nó là một rào cản cơ bản đối với việc áp dụng rộng rãi AI tác nhân ở những môi trường có rủi ro cao do thực hiện quản trị khó khăn. Khi một tác nhân có thể thực hiện giao dịch tài chính, quản lý dữ liệu khách hàng, hoặc tương tác với các hệ thống quan trọng đối với doanh nghiệp khác, việc thiếu tính minh bạch không chỉ là một thiếu sót—đó là một rủi ro vận hành đáng kể. Quản lý hiệu quả vấn đề này là trung tâm của trách nhiệm tác nhân AI.

Điểm Nhấn Quan Trọng

- Vấn đề ‘hộp đen’ trong tác nhân AI là về việc hiểu quy trình ra quyết định của chúng, không chỉ đơn thuần là sản phẩm đầu ra văn bản của chúng.

- Phân tích ‘dấu vết’ hoặc nhật ký quyết định của một tác nhân là cách hiệu quả nhất để gỡ lỗi hành vi của nó và hiểu rõ lý do của nó.

- Các kỹ thuật AI giải thích được (XAI) cung cấp những hiểu biết có giá trị về các quyết định của tác nhân nhưng không hoàn toàn làm hộp đen trở nên trong suốt.

- Thiết kế các tác nhân với tính mô-đun và sử dụng mô hình đơn giản hơn cho các nhiệm vụ quan trọng có thể cải thiện tính minh bạch một cách tự nhiên và giảm rủi ro.

- Các quy trình làm việc có sự can thiệp của con người (HITL), nơi một người phê duyệt các hành động quan trọng, vẫn là chiến lược đáng tin cậy nhất để đảm bảo trách nhiệm của tác nhân AI.

Điều quan trọng là phân biệt giữa vấn đề hộp đen trong một Mô hình Ngôn ngữ Lớn (LLM) tiêu chuẩn và trong một tác nhân AI.

- Hộp Đen LLM: Bí ẩn nằm ở việc tạo nội dung. Chúng ta không hoàn toàn biết tại sao mô hình lại chọn một chuỗi từ cụ thể để tạo thành một câu.

- Hộp Đen Tác Nhân: Bí ẩn nằm ở quyết định. Chúng ta không hoàn toàn biết tại sao tác nhân lại chọn thực hiện một hành động cụ thể (như gọi một công cụ hoặc gửi email) thay vì hành động khác. Sự chú ý chuyển từ việc thông dịch từ sang việc thông dịch quyết định của tác nhân AI.

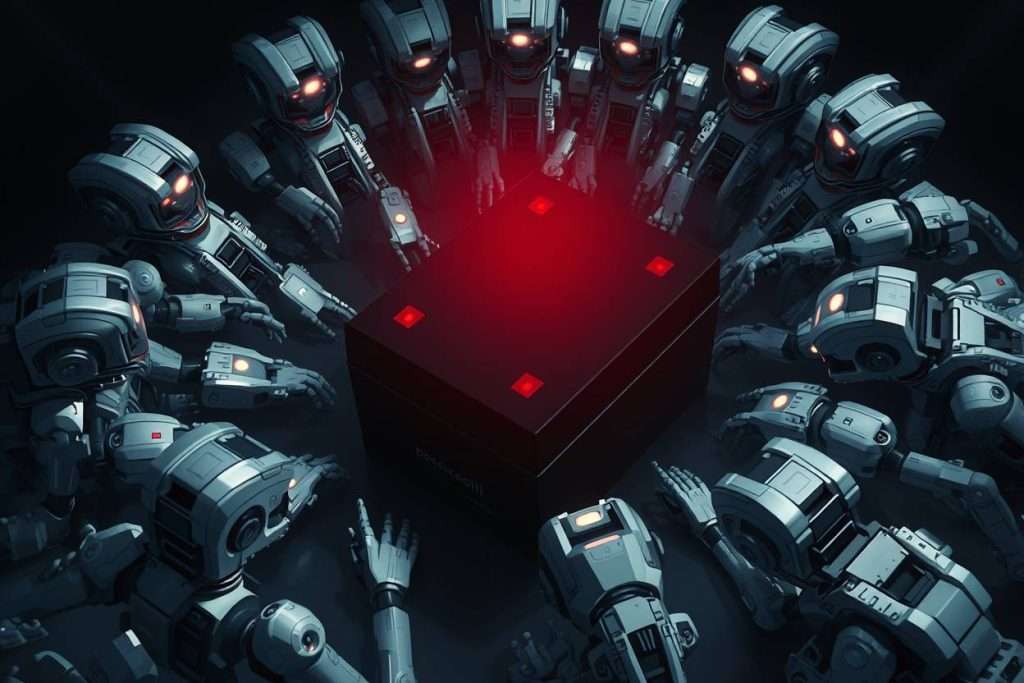

Vấn đề hộp đen được phóng đại trong các hệ thống tự động vì khả năng xảy ra các hậu quả lũy tiến.

- Thất bại Lũy Tiến: Một quyết định xấu không giải thích được có thể kích hoạt một loạt các hành động tự động có hại, biến một lỗi nhỏ thành một sự cố lớn.

- Sự không thể Trách nhiệm: Nếu bạn không biết tại sao một tác nhân lại hành động, bạn không thể quy trách nhiệm, sửa lỗi gốc, hoặc ngăn chặn điều đó xảy ra lần nữa. Điều này làm cho việc kiểm toán tác nhân AI gần như không thể.

- Sự Xói Mòn Niềm Tin: Người dùng và người vận hành sẽ không—và không nên—dựa vào các hệ thống mà họ không thể hiểu lý do, đặc biệt khi rủi ro cao.

Làm thế nào Chúng Ta Có Thể ‘Nhìn Vào Bên Trong Hộp Đen’? Sức Mạnh của Sự Quan Sát

Kỹ thuật cơ bản và thực tiễn nhất để tăng độ minh bạch của tác nhân AI là khả năng quan sát. Điều này có nghĩa là có khả năng giám sát và hiểu trạng thái nội bộ cũng như quá trình lý luận của tác nhân tại mỗi bước.

‘Vết tích tác nhân’ là một bản ghi chi tiết, từng bước về ‘quá trình suy nghĩ’ nội bộ của tác nhân. Đây là công cụ chính để kiểm toán tác nhân AI và hiểu hành vi của chúng. Một vết tích tốt ghi lại các thành phần chính của vòng xoay lý luận của tác nhân:

- Kế hoạch tổng thể của tác nhân để đạt được mục tiêu của nó.

- Các công cụ cụ thể mà nó chọn sử dụng tại mỗi bước.

- Dữ liệu đầu vào chính xác mà nó cung cấp cho các công cụ đó.

- Đầu ra chính xác mà nó nhận được từ các công cụ.

Vết tích cho phép bạn vượt qua đầu ra cuối cùng đã thất bại và xác định chính xác bước mà logic của tác nhân sai ở đâu. Bằng cách xem lại các nhật ký quyết định của tác nhân AI, các nhà phát triển có thể xác định liệu thất bại do kế hoạch sai lầm, sử dụng công cụ không đúng, hay lỗi bên ngoài gây ra. Đây là nền tảng của trách nhiệm giải trình tác nhân AI thực tiễn.

Các Kỹ Thuật Thực Tiễn Để Giải Thích Quyết Định Của Tác Nhân Là Gì? (AI Giải Thích – XAI)

AI Giải Thích (XAI) là một tập hợp các phương pháp được thiết kế để làm cho các quyết định AI dễ hiểu hơn. Đối với các hệ thống tác nhân, một số kỹ thuật đặc biệt hữu ích để tạo ra các tác nhân AI giải thích được.

Đây là một kỹ thuật đơn giản nhưng mạnh mẽ, nơi bạn hướng dẫn tác nhân diễn giải suy nghĩ của mình trước khi hành động. Bằng cách thêm một quy tắc vào gợi ý của tác nhân như, ‘Trước khi sử dụng bất kỳ công cụ nào, hãy giải thích lý do, kế hoạch của bạn, và công cụ bạn sẽ sử dụng,’ bạn buộc nó tạo ra một lời giải thích bằng ngôn ngữ tự nhiên về mục đích của mình, điều này sau đó được ghi lại trong truy vết của tác nhân.

- LIME là một kỹ thuật XAI phổ biến để giải thích quyết định của tác nhân AI từng bước một. Nó hoạt động bằng cách tạo ra một mô hình ‘giải thích’ đơn giản, tạm thời quanh một quyết định cụ thể do tác nhân phức tạp thực hiện. Điều này cho phép bạn hiểu những yếu tố nào có ảnh hưởng lớn nhất đến trường hợp cụ thể đó, mà không cố gắng hiểu toàn bộ mô hình phức tạp ngay lập tức.

- SHAP là một phương pháp mạnh mẽ khác để tạo tác nhân AI có thể giải thích được. Nó gán một ‘giá trị quan trọng’ cho từng tính năng đầu vào đã đóng góp vào một quyết định. Ví dụ, nó có thể hiển thị rằng đối với tác nhân phê duyệt khoản vay, điểm tín dụng của người nộp đơn đã đóng góp +0.5 vào quyết định ‘phê duyệt’, trong khi tỷ lệ nợ trên thu nhập đóng góp -0.3. Điều này cung cấp cái nhìn định lượng hơn về quá trình ra quyết định.

Làm thế nào bạn có thể thiết kế các tác nhân để minh bạch từ đầu?

Đạt được tính minh bạch của các tác nhân AI không chỉ là phân tích sau này; nó còn là việc đưa ra các lựa chọn kiến trúc thông minh trong giai đoạn thiết kế.

Đây là một thực tế nổi tiếng trong học máy rằng các mô hình mạnh mẽ nhất thường là những mô hình không rõ ràng nhất. Khi thiết kế một tác nhân, bạn phải cân nhắc sự đánh đổi này. Đối với các tiểu nhiệm vụ quan trọng mà khả năng giải thích là tối quan trọng, có thể tốt hơn khi sử dụng một mô hình đơn giản hơn, minh bạch hơn (như cây quyết định hoặc mô hình hồi quy tuyến tính) thay vì một mạng nơ-ron khổng lồ.

Thay vì xây dựng một tác nhân đơn lẻ, nguyên khối để làm mọi thứ, một cách tiếp cận tốt hơn là thiết kế một nhóm các tác nhân nhỏ hơn, có mục đích đơn lẻ. Hành vi của các tác nhân nhỏ hơn, chuyên biệt này dễ dàng hơn để kiểm tra, xác thực và hiểu. Thiết kế mô-đun này là một chiến lược quan trọng để xây dựng các tác nhân AI dễ quản lý hơn và có thể giải thích được.

Vai trò của ‘Human-in-the-Loop’ trong quản lý rủi ro Black Box là gì?

Chiến lược đáng tin cậy nhất, không kỹ thuật để quản lý các rủi ro của AI không rõ ràng là đảm bảo sự giám sát có ý nghĩa từ con người.

Bất kể tác nhân phức tạp hay không rõ ràng đến đâu, một điểm cuối cùng của sự phán đoán con người có thể ngăn chặn các hành động có hại được thực hiện. Đây là nền tảng của việc triển khai AI có trách nhiệm và là điều cần thiết cho sự chịu trách nhiệm của các tác nhân AI trong thế giới thực.

Một mẫu thiết kế phổ biến và hiệu quả là quy trình ‘xem xét và phê duyệt’. Trong hệ thống này, tác nhân có thể thực hiện tất cả các nghiên cứu, phân tích và lập kế hoạch cần thiết, nhưng nó phải trình bày hành động đề xuất của mình cho một nhà điều hành con người để được phê duyệt cuối cùng trước khi được phép thực hiện. Đây là một cách thực tế để kiểm toán các tác nhân AI theo thời gian thực.

Để hệ thống human-in-the-loop hoạt động, giao diện phải hiệu quả. Một bảng điều khiển tốt cần hiển thị rõ ràng kế hoạch đề xuất của tác nhân, các dữ liệu chính mà nó đã sử dụng để đạt được kế hoạch đó và điểm số tự tin của nó. Điều này cho phép nhà điều hành con người đưa ra quyết định nhanh chóng và thông báo về việc có phê duyệt hay từ chối hành động đề xuất của tác nhân.

Có những hiểu lầm phổ biến nào về Vấn đề Hộp Đen?

Để quản lý đúng thách thức này, trước tiên chúng ta phải phá bỏ một số huyền thoại phổ biến.

Thực tế là các kỹ thuật XAI cung cấp những hiểu biết và xấp xỉ có giá trị về lý do của một tác nhân. Chúng không cung cấp một giải thích hoàn hảo, quyết định về cách thức hoạt động phức tạp bên trong của một mạng nơ-ron. Chúng làm cho ‘hộp đen’ trở nên ít mờ đục hơn, nhưng không hoàn toàn loại bỏ nó.

Thực tế là đối với các mô hình học sâu mạnh mẽ nhất, một mức độ mờ đục là một sự đánh đổi vốn có cho hiệu suất cao của chúng. Mục tiêu của tính minh bạch trong tác nhân AI là để quản lý sự mờ đục này thông qua khả năng quan sát, giải thích và giám sát, không nhất thiết xóa bỏ nó hoàn toàn.

Kết luận: Từ Kiểm soát Tuyệt đối đến Niềm tin Thông điệp

Các công cụ trong quá khứ đã được hiểu rõ và kiểm soát trực tiếp; chúng ta biết mọi quy tắc trong máy. Các tác nhân AI trong tương lai lại khác biệt. Chúng là những đối tác mà lý do nội bộ có thể không bao giờ được hoàn toàn minh bạch với chúng ta. Do đó, việc quản lý vấn đề ‘hộp đen’ và cải thiện tính minh bạch của các tác nhân AI không chỉ là một thách thức kỹ thuật—mà còn là một thách thức triết học.

Điều này đánh dấu một sự thay đổi căn bản trong mối quan hệ của chúng ta với công nghệ, chuyển từ việc cần kiểm soát tuyệt đối sang sự cần thiết xây dựng các hệ thống mà, dù không hoàn toàn hiểu, có thể đạt được niềm tin thông điệp của chúng ta thông qua các quá trình mạnh mẽ về khả năng quan sát, chịu trách nhiệm và giám sát.